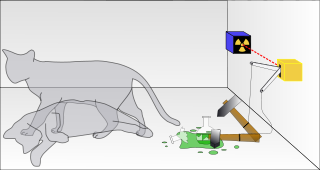

Observación y función de onda son dos de los elementos de más sinuosa interpretación ontológica en el ámbito de la mecánica cuántica, y sobre los que el debate filosófico no cesa. Son múltiples los experimentos mentales concebidos a colación de la traslación a nivel macroscópico de fenómenos cuánticos en los que los citados conceptos juegan un papel central. El gato de Schrödinger es posiblemente el más conocido a nivel popular, y sobre la base del mismo se han construido escenarios más complejos en los que la participación de observadores adicionales pone a prueba la sutileza de los conceptos mencionados. Por ejemplo, ya comentamos hace tiempo el experimento del amigo de Wigner, una especie de versión matrioshka del gato de Schrödinger en el que se construye una cadena de observadores conscientes en cajas concéntricas, y que pone el acento en la relación entre consciencia y observación. Otro experimento relacionado con este extremo es el denominado suicidio cuántico.

El experimento del gato de Schrödinger

La disposición de este experimento puede variar, pero para simplificar podemos imaginarnos que sustituimos al gato de Schrödinger por el propio Schrödinger, y que observamos el experimento desde su punto de vista. Supongamos por ejemplo que lo que hace Schrödinger es activar un dispositivo que incorpora un generador cuántico de números aleatorios que provocará o no el disparo de un cierto dispositivo letal incluido en la caja. El bueno de Schrödinger tiene una cierta probabilidad de sobrevivir, pero si repite el experimento una y otra vez la ruleta cuántica terminará por tocarle y su existencia tocará a su fin… o no. Y es que de acuerdo con la interpretación de los múltiples universos, cada vez que se activa el dispositivo se produce una ramificación en un universo en el que Schrödinger muere y otro en el que sobrevive. Es únicamente en este segundo universo en el que Schrödinger puede jugar de nuevo, y en el que se produce una nueva bifurcación. Eso quiere decir que existe un universo en el que –para incredulidad de Schrödinger, que llegará a sentirse invulnerable– siempre sobrevive. En este caso se puede hablar apropiadamente de inmortalidad cuántica. Nótese la reminiscencia antrópica del experimento, ya que el razonamiento sobre la propia existencia requiere que se sobreviva al experimento.

Viene todo esto a cuento de un comentario en Accelerating Future acerca de los nuevos problemas detectados en el LHC y que una vez más provocan un retraso en su puesta en funcionamiento. Concretamente, en esta ocasión se han detectado dos fugas entre el circuito de helio y el aislamiento de vacío, lo que en principio provocará que el reinicio del LHC no se produzca hasta mediados de noviembre. Recordemos que este es el tercer incidente serio que afecta a la fecha de entrada en estado operacional del LHC, tras la explosión de la envoltura criostática de uno de los gigantescos imanes cruadrupolos el 27 de marzo de 2007, y de un escape masivo de helio líquido el 19 de septiembre de 2008. Estos incidentes en modo alguno comprometen la seguridad del LHC, y de hecho no tienen nada que ver con los hipotéticos riesgos existenciales (e.g., creación de microagujeros negros estables, materia extraña, etc.) del mismo, cuidadosamente estudiados y descartados. No obstante, si hay alguien que aún abriga algún temor (o está deseando hacerlo), aquí puede encontrar una fuente adicional de inquietud: si el LHC fuera un dispositivo que desencadenara el Apocalipsis una vez activado, y de ser correcta la interpretación de los múltiples universos de la mecánica cuántica, estaríamos en la misma disposición que Schrödinger en el experimento del suicidio cuántico. Existiría entonces un universo en el que veríamos que el LHC fallaría persistentemente (en los universos en los que no fallara cesaría nuestra existencia). La ocurrencia de nuevos incidentes -tanto más si estos son cada vez más improbables- que continuaran retrasando la plena operatividad del LHC podría hacer que alguien se planteara si no estamos en la línea de universo “afortunada” (eso, y que los ingenieros del CERN serían como los mecánicos de Fernando Alonso, claro).

Si alguien ha llegado a inquietarse realmente con lo anterior, puede reconfortarse en el hecho de que está sujeto a la interpretación de los múltiples universos, de que lo acontecido hasta ahora no entra dentro de lo excepcional, y de que la puesta en marcha del LHC está prevista para otoño de este año, por lo que en el peor caso tenemos todo el verano por delante.